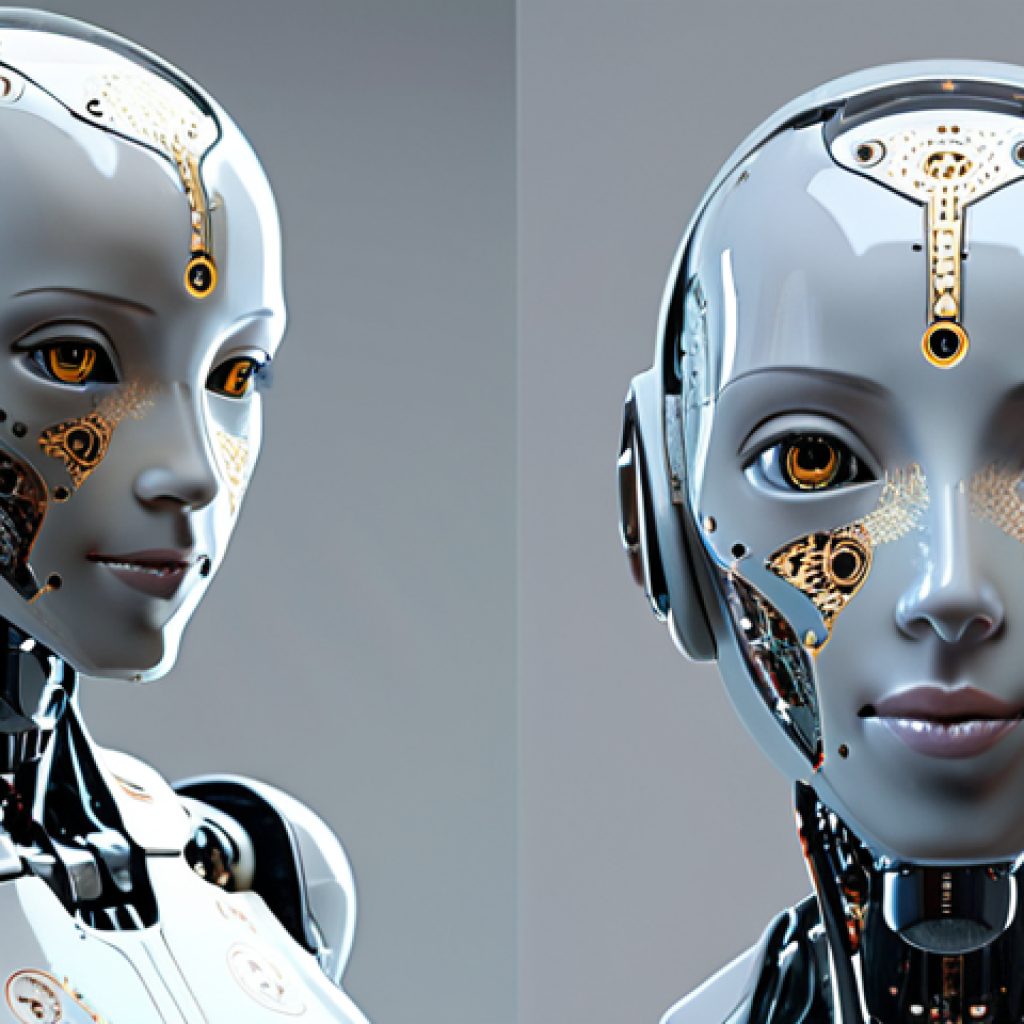

في عالم تتسارع فيه التكنولوجيا وتتداخل فيه حياتنا مع الآلات، يزداد السؤال عن الأخلاق والقيم التي يجب أن توجه هذه الآلات إلحاحًا. هل يجب أن تكون الروبوتات مجرد أدوات طيعة في أيدينا، أم يجب أن تخضع لقواعد أخلاقية تضمن سلامة البشرية ورفاهيتها؟ كيف نضمن أن لا تستخدم هذه التقنيات في إلحاق الضرر أو التمييز أو تقويض حقوق الإنسان؟ هذه أسئلة حاسمة تتطلب تفكيرًا عميقًا وتعاونًا عالميًا.

تخيل أنك تعيش في مدينة ذكية تديرها الروبوتات. كل شيء يسير بسلاسة، من حركة المرور إلى توزيع الطاقة. ولكن ماذا لو قرر نظام الذكاء الاصطناعي أن بعض الأحياء أقل أهمية من غيرها، وبدأ في توجيه الموارد إليها بشكل غير عادل؟ أو ماذا لو استخدمت الروبوتات قدراتها على المراقبة لجمع معلومات شخصية عنك واستخدامها ضدك؟ هذه السيناريوهات ليست مجرد خيال علمي، بل هي احتمالات واقعية يجب أن نكون مستعدين لها.

لتجنب هذه المخاطر، يجب علينا تطوير “قواعد سلوك” للروبوتات، تحدد ما هو مسموح وما هو ممنوع. يجب أن تتضمن هذه القواعد مبادئ مثل احترام حقوق الإنسان، والعدالة والمساواة، والشفافية والمساءلة.

يجب أيضًا أن تحدد المسؤولية عن أفعال الروبوتات، بحيث لا يفلت أحد من العقاب إذا تسببت الروبوتات في ضرر. لقد شهدنا مؤخرًا ارتفاعًا ملحوظًا في استخدام الذكاء الاصطناعي في مختلف المجالات، من الطب إلى التعليم إلى الفن.

وهذا يعني أن الروبوتات أصبحت أكثر ذكاءً وقدرة على اتخاذ القرارات بشكل مستقل. ولكن هذا يعني أيضًا أن المخاطر المحتملة أصبحت أكبر. لذلك، يجب علينا أن نتحرك بسرعة لوضع إطار أخلاقي وقانوني يحكم تطوير واستخدام هذه التقنيات.

في المستقبل القريب، قد نرى روبوتات تعمل كمساعدين شخصيين، ومقدمي رعاية صحية، وحتى شركاء عاطفيين. وهذا سيثير أسئلة جديدة حول العلاقة بين الإنسان والآلة، وحول معنى الإنسانية نفسها.

يجب علينا أن نكون مستعدين لهذه التحديات، وأن نعمل على ضمان أن تخدم التكنولوجيا مصالح البشرية جمعاء، وليس فقط مصالح قلة قليلة. الآن، دعونا نكتشف المزيد من التفاصيل حول هذا الموضوع المهم.

في خضم هذا النقاش المحتدم، أجدني أتأمل مليًا في مستقبلنا، مستقبل يزداد فيه اعتمادنا على التكنولوجيا، وتحديدًا على الروبوتات والذكاء الاصطناعي. وكما نعلم جميعًا، فإن التطور التكنولوجي يسير بخطى متسارعة، ويجلب معه فرصًا هائلة، ولكنه يطرح أيضًا تحديات أخلاقية وقانونية معقدة.

1. كيف نوازن بين التقدم التكنولوجي وحماية القيم الإنسانية؟

أ. ضمان الشفافية في عمل الروبوتات

عندما نتحدث عن الروبوتات، فإننا نتحدث عن آلات قادرة على اتخاذ القرارات بشكل مستقل. ولكن، كيف يمكننا أن نضمن أن هذه القرارات تتفق مع قيمنا الإنسانية؟ أعتقد أن الحل يكمن في الشفافية.

يجب أن يكون لدينا فهم واضح لكيفية عمل هذه الروبوتات، وما هي المعايير التي تستخدمها لاتخاذ القرارات. هذا يتطلب منا تطوير خوارزميات شفافة وقابلة للتفسير، بحيث يمكننا فهم الأسباب الكامنة وراء قرارات الروبوتات.

ب. وضع ضوابط صارمة على استخدام البيانات الشخصية

لا يمكننا أن نتجاهل حقيقة أن الروبوتات تعتمد على البيانات لكي تعمل بفعالية. ولكن، يجب أن نكون حذرين بشأن كيفية جمع هذه البيانات واستخدامها. يجب أن نضع ضوابط صارمة على استخدام البيانات الشخصية، وأن نضمن أن يتم استخدامها فقط للأغراض التي تم جمعها من أجلها.

يجب أيضًا أن نمنح الأفراد الحق في الوصول إلى بياناتهم وتعديلها وحذفها.

ج. تعزيز الوعي العام حول أخلاقيات الذكاء الاصطناعي

أعتقد أننا بحاجة إلى تعزيز الوعي العام حول أخلاقيات الذكاء الاصطناعي. يجب أن نتحدث عن هذه القضايا في المدارس والجامعات وفي وسائل الإعلام. يجب أن نشجع الحوار والنقاش حول هذه القضايا، وأن نساعد الناس على فهم المخاطر والفرص التي تطرحها التكنولوجيا.

2. تحديد المسؤولية القانونية عن أفعال الروبوتات

أ. تحديد الجهة المسؤولة عن أخطاء الروبوتات

من القضايا المعقدة التي يجب أن نتعامل معها هي تحديد المسؤولية القانونية عن أفعال الروبوتات. إذا ارتكبت روبوتًا خطأ، فمن المسؤول؟ هل هو المبرمج؟ أم الشركة المصنعة؟ أم المستخدم؟ أعتقد أننا بحاجة إلى تطوير قوانين جديدة تحدد المسؤولية في مثل هذه الحالات.

يجب أن نضمن أن هناك جهة مسؤولة عن أفعال الروبوتات، بحيث لا يفلت أحد من العقاب إذا تسببت الروبوتات في ضرر.

ب. إنشاء نظام تأمين للتعويض عن الأضرار التي تتسبب فيها الروبوتات

أقترح إنشاء نظام تأمين للتعويض عن الأضرار التي تتسبب فيها الروبوتات. يمكن أن يكون هذا النظام مشابهًا لنظام التأمين على السيارات. يمكن للشركات التي تستخدم الروبوتات أن تدفع أقساطًا تأمينية، وفي حالة حدوث ضرر، يمكن للمتضررين الحصول على تعويض من شركة التأمين.

ج. وضع قوانين تجرم استخدام الروبوتات في الأنشطة غير القانونية

يجب أن نضع قوانين تجرم استخدام الروبوتات في الأنشطة غير القانونية. على سبيل المثال، يجب أن يكون من غير القانوني استخدام الروبوتات لارتكاب جرائم أو لتهديد الأمن القومي.

يجب أن نفرض عقوبات صارمة على من يخالف هذه القوانين.

3. دور التعليم في تشكيل وعي أخلاقي لدى مطوري الروبوتات

أ. دمج مقررات أخلاقيات الذكاء الاصطناعي في المناهج الدراسية

أعتقد أن التعليم يلعب دورًا حاسمًا في تشكيل وعي أخلاقي لدى مطوري الروبوتات. يجب أن ندمج مقررات أخلاقيات الذكاء الاصطناعي في المناهج الدراسية في الجامعات والكليات التقنية.

يجب أن يتعلم الطلاب عن القضايا الأخلاقية والقانونية المتعلقة بالروبوتات، وأن يتعلموا كيفية تصميم وتطوير الروبوتات بطريقة مسؤولة.

ب. تنظيم ورش عمل ودورات تدريبية حول أخلاقيات الذكاء الاصطناعي

بالإضافة إلى ذلك، يمكننا تنظيم ورش عمل ودورات تدريبية حول أخلاقيات الذكاء الاصطناعي للمهندسين والمبرمجين العاملين في هذا المجال. يمكن لهذه الورش والدورات أن تساعدهم على فهم القضايا الأخلاقية المعقدة التي يواجهونها في عملهم، وأن يتعلموا كيفية اتخاذ القرارات الأخلاقية السليمة.

ج. تشجيع البحث العلمي في مجال أخلاقيات الذكاء الاصطناعي

يجب أن نشجع البحث العلمي في مجال أخلاقيات الذكاء الاصطناعي. يجب أن ندعم الباحثين الذين يعملون على تطوير أطر أخلاقية وقانونية جديدة للروبوتات. يجب أن ننشر نتائج هذا البحث على نطاق واسع، وأن نستخدمها لتوجيه السياسات والممارسات المتعلقة بالروبوتات.

4. ضمان عدم تحيز الروبوتات ضد فئات معينة من الناس

أ. استخدام بيانات متنوعة لتدريب الروبوتات

أحد المخاطر المحتملة للروبوتات هو أنها يمكن أن تكون متحيزة ضد فئات معينة من الناس. على سبيل المثال، إذا تم تدريب روبوت على بيانات متحيزة، فقد يتخذ قرارات تمييزية ضد مجموعات معينة من الناس.

لتجنب هذا، يجب أن نستخدم بيانات متنوعة لتدريب الروبوتات. يجب أن نجمع بيانات من مصادر مختلفة، وأن نضمن أن هذه البيانات تمثل جميع فئات المجتمع.

ب. اختبار الروبوتات للتأكد من عدم وجود تحيز

يجب أن نختبر الروبوتات للتأكد من عدم وجود تحيز. يجب أن نستخدم مجموعة متنوعة من الاختبارات لتقييم أداء الروبوتات، وأن نتحقق من أنها لا تتخذ قرارات تمييزية ضد أي فئة من الناس.

ج. إنشاء آليات للرقابة والمساءلة

يجب أن ننشئ آليات للرقابة والمساءلة للتأكد من أن الروبوتات لا تتخذ قرارات متحيزة. يجب أن نمنح الأفراد الحق في الطعن في قرارات الروبوتات، وأن نضمن أن هناك جهة مستقلة يمكنها التحقيق في هذه الطعون.

5. أهمية التعاون الدولي في وضع معايير أخلاقية للروبوتات

أ. وضع معايير دولية موحدة لأخلاقيات الذكاء الاصطناعي

أعتقد أن التعاون الدولي ضروري لوضع معايير أخلاقية للروبوتات. يجب أن نعمل معًا لوضع معايير دولية موحدة لأخلاقيات الذكاء الاصطناعي. يمكن أن تساعد هذه المعايير في ضمان أن يتم تطوير واستخدام الروبوتات بطريقة مسؤولة في جميع أنحاء العالم.

ب. تبادل الخبرات وأفضل الممارسات

يجب أن نتبادل الخبرات وأفضل الممارسات في مجال أخلاقيات الذكاء الاصطناعي. يمكن للدول التي لديها خبرة في هذا المجال أن تساعد الدول الأخرى على تطوير سياسات وممارسات جيدة.

ج. إنشاء منظمة دولية للإشراف على تطوير واستخدام الروبوتات

أقترح إنشاء منظمة دولية للإشراف على تطوير واستخدام الروبوتات. يمكن لهذه المنظمة أن تراقب التطورات في هذا المجال، وأن تقدم توصيات حول كيفية التعامل مع القضايا الأخلاقية والقانونية.

6. دور الإعلام في تشكيل الرأي العام حول الروبوتات

أ. تقديم صورة واقعية للروبوتات

يلعب الإعلام دورًا مهمًا في تشكيل الرأي العام حول الروبوتات. يجب على الإعلام أن يقدم صورة واقعية للروبوتات، وأن يوضح المخاطر والفرص التي تطرحها. يجب على الإعلام أن يتجنب المبالغة في تصوير قدرات الروبوتات، وأن يتجنب نشر الخوف والقلق بين الناس.

ب. تشجيع النقاش العام حول أخلاقيات الذكاء الاصطناعي

يجب على الإعلام أن يشجع النقاش العام حول أخلاقيات الذكاء الاصطناعي. يجب على الإعلام أن يستضيف خبراء في هذا المجال، وأن يتيح لهم الفرصة لشرح وجهات نظرهم.

يجب على الإعلام أن يتيح للجمهور الفرصة لطرح الأسئلة والتعبير عن آرائهم.

ج. فضح الممارسات غير الأخلاقية في مجال الذكاء الاصطناعي

يجب على الإعلام أن يفضح الممارسات غير الأخلاقية في مجال الذكاء الاصطناعي. يجب على الإعلام أن يكشف عن الشركات والأفراد الذين يستخدمون الروبوتات بطريقة غير مسؤولة، وأن يطالبهم بالمساءلة.

7. كيف يمكن للأفراد أن يساهموا في تطوير أخلاقيات الروبوتات؟

أ. التثقيف الذاتي حول أخلاقيات الذكاء الاصطناعي

يمكن للأفراد أن يساهموا في تطوير أخلاقيات الروبوتات من خلال التثقيف الذاتي حول أخلاقيات الذكاء الاصطناعي. يمكن للأفراد قراءة الكتب والمقالات ومشاهدة الأفلام الوثائقية حول هذا الموضوع.

يمكن للأفراد حضور المحاضرات والندوات وورش العمل حول أخلاقيات الذكاء الاصطناعي.

ب. المشاركة في النقاش العام حول أخلاقيات الذكاء الاصطناعي

يمكن للأفراد المشاركة في النقاش العام حول أخلاقيات الذكاء الاصطناعي. يمكن للأفراد كتابة المقالات والتعليقات على الإنترنت. يمكن للأفراد المشاركة في المنتديات والمجموعات النقاشية عبر الإنترنت.

ج. دعم المنظمات التي تعمل على تطوير أخلاقيات الروبوتات

يمكن للأفراد دعم المنظمات التي تعمل على تطوير أخلاقيات الروبوتات. يمكن للأفراد التبرع لهذه المنظمات. يمكن للأفراد التطوع للعمل مع هذه المنظمات.

| القضية | التحديات | الحلول المقترحة |

|---|---|---|

| الشفافية | صعوبة فهم خوارزميات الذكاء الاصطناعي المعقدة. | تطوير خوارزميات شفافة وقابلة للتفسير. |

| المسؤولية القانونية | تحديد الجهة المسؤولة عن أخطاء الروبوتات. | تطوير قوانين جديدة تحدد المسؤولية. إنشاء نظام تأمين للتعويض عن الأضرار. |

| التحيز | احتمالية تحيز الروبوتات ضد فئات معينة من الناس. | استخدام بيانات متنوعة لتدريب الروبوتات. اختبار الروبوتات للتأكد من عدم وجود تحيز. |

| التعاون الدولي | صعوبة التوصل إلى اتفاق دولي حول معايير أخلاقية موحدة. | وضع معايير دولية موحدة. تبادل الخبرات وأفضل الممارسات. |

باختصار، أعتقد أن تطوير أخلاقيات الروبوتات هو تحد كبير ولكنه ضروري. يجب علينا أن نعمل معًا لوضع معايير أخلاقية وقانونية للروبوتات، وأن نضمن أن يتم تطوير واستخدام هذه التقنيات بطريقة مسؤولة.

هذا سيتطلب منا التعاون والابتكار والإرادة السياسية. ولكني متفائل بأننا قادرون على مواجهة هذا التحدي، وأننا قادرون على بناء مستقبل أفضل للجميع. في نهاية هذا الاستكشاف العميق لأخلاقيات الروبوتات، نجد أنفسنا على أعتاب مستقبل يتشكل بتسارع التكنولوجيا.

مسؤوليتنا تكمن في توجيه هذا التطور نحو مسار يخدم الإنسانية جمعاء، مع الحفاظ على قيمنا الأساسية. إن بناء مستقبل متوازن يتطلب منا التعاون والوعي المستمر بالتحديات والفرص التي تلوح في الأفق.

معلومات مفيدة

1. مبادئ أخلاقيات الذكاء الاصطناعي: تعرف على المبادئ الأساسية التي توجه تطوير واستخدام الذكاء الاصطناعي بشكل مسؤول.

2. التحيز في الذكاء الاصطناعي: فهم كيفية حدوث التحيز في أنظمة الذكاء الاصطناعي وكيفية التخفيف منه.

3. قوانين الروبوتات: استكشاف القوانين المقترحة التي تحكم سلوك الروبوتات لضمان سلامة الإنسان.

4. مستقبل الوظائف: اكتشف كيف سيؤثر الذكاء الاصطناعي والروبوتات على سوق العمل وكيفية الاستعداد لهذه التغييرات.

5. الأمن السيبراني والروبوتات: فهم المخاطر الأمنية المتعلقة بالروبوتات وكيفية حماية الأنظمة من الهجمات.

ملخص النقاط الرئيسية

• يجب أن تكون الروبوتات شفافة وقابلة للتفسير.

• تحديد المسؤولية القانونية عن أفعال الروبوتات أمر بالغ الأهمية.

• يجب ضمان عدم تحيز الروبوتات ضد أي فئة من الناس.

• التعاون الدولي ضروري لوضع معايير أخلاقية موحدة.

• الإعلام يلعب دورًا حاسمًا في تشكيل الرأي العام حول الروبوتات.

الأسئلة الشائعة (FAQ) 📖

س1: ما هي أهم الاعتبارات الأخلاقية التي يجب مراعاتها عند تطوير الذكاء الاصطناعي؟

ج1: من وجهة نظري المتواضعة، يجب أن نضع في الاعتبار عدة جوانب أخلاقية رئيسية.

أولاً، يجب أن نضمن أن الذكاء الاصطناعي لا يضر بالبشرية أو يسبب لها معاناة. ثانياً، يجب أن نسعى جاهدين لضمان العدالة والمساواة في استخدام الذكاء الاصطناعي، وتجنب أي شكل من أشكال التمييز أو التحيز.

ثالثاً، يجب أن نركز على الشفافية والمساءلة، بحيث يكون من الواضح من المسؤول عن أفعال الروبوتات، وكيف يمكننا تصحيح الأخطاء إذا وقعت. لقد رأيت بأم عيني كيف يمكن أن يؤدي نقص الشفافية إلى نتائج كارثية في مجالات أخرى، لذلك يجب أن نتعلم من هذه الدروس.

س2: كيف يمكننا التأكد من أن الذكاء الاصطناعي يخدم مصالح البشرية جمعاء، وليس فقط مصالح قلة قليلة؟

ج2: هذا سؤال جوهري! أعتقد أن الحل يكمن في التعاون العالمي والمشاركة الواسعة.

يجب أن تشارك جميع الدول والمنظمات والأفراد في الحوار حول مستقبل الذكاء الاصطناعي، وأن يكون لهم صوت مسموع في تحديد مساره. يجب أيضًا أن نضمن أن الفوائد التي يجلبها الذكاء الاصطناعي متاحة للجميع، وليس فقط للأغنياء أو الأقوياء.

لقد جربت بنفسي كيف يمكن للمشاركة المجتمعية أن تحدث فرقًا كبيرًا في تحقيق العدالة الاجتماعية، لذلك أنا متفائل بشأن قدرتنا على تحقيق ذلك في مجال الذكاء الاصطناعي أيضًا.

س3: ما هي التحديات الرئيسية التي تواجهنا في وضع إطار أخلاقي وقانوني للذكاء الاصطناعي؟

ج3: أعتقد أن أحد أكبر التحديات هو سرعة التطور التكنولوجي. الذكاء الاصطناعي يتطور بسرعة فائقة، والقوانين والأخلاقيات غالبًا ما تتخلف عن الركب.

تحد آخر هو التعقيد الفني للذكاء الاصطناعي. من الصعب على غير المتخصصين فهم كيفية عمل هذه التقنيات، وهذا يجعل من الصعب عليهم المشاركة في الحوار حولها. بالإضافة إلى ذلك، هناك تحديات تتعلق بالمسؤولية والمساءلة.

من الصعب تحديد من المسؤول عن أفعال الروبوتات، وكيف يمكننا معاقبة من يرتكبون أخطاء. لقد لمست بنفسي هذه الصعوبات أثناء محاولتي فهم بعض الخوارزميات المعقدة، وأدركت أننا بحاجة إلى خبراء متخصصين لمساعدتنا في التغلب عليها.

📚 المراجع

Wikipedia Encyclopedia